SkyReels-V2和SkyReels-V1相比,各有什么特点?

AI资讯 2025-05-26

SkyReels-V2 的改进的地方与特点:

- 无限时长视频生成

- 扩散强迫框架(Diffusion Forcing):SkyReels-V2 通过非递减噪声时间表和自回归令牌级去噪技术,突破了传统视频生成模型在时长上的限制,能够生成理论上无限长的视频。

- 滑动窗口方法:在生成新帧时参考之前生成的帧和文本提示,通过稳定化技术防止错误积累,支持时间上的扩展。

- 高质量视频生成

- 影视级视频理解模型 SkyCaptioner-V1:能够识别视频中的主体类型、表情、动作等信息,提升镜头语言理解能力,显著提高生成视频的提示词遵循能力。

- 强化学习优化:通过人工标注和合成失真数据进行强化学习,优化运动质量,生成流畅且逼真的视频内容。

- 渐进式分辨率预训练:从低分辨率逐步提升到高分辨率,确保生成内容的视觉质量达到专业标准。

- 多任务支持

- 文本到视频(T2V):根据文本描述生成视频,支持无限时长的连贯视频生成。

- 图像到视频(I2V):将静态图像转化为连贯的视频。

- 故事生成:通过滑动窗口方法生成具有连贯叙事的长镜头视频。

- 摄像导演功能:自动生成推拉摇移等电影级运镜效果。

- 性能提升

- 高效推理框架:支持多 GPU 并行计算,通过量化技术降低内存需求,推理效率大幅提高。

- 动态质量优化:在运动动态性、流畅性和物理合理性方面表现出色,生成的运动内容自然且多样。

- 开源

- SkyReels-V2 的模型及相关代码已完全开源,支持学术界和工业界的进一步研究和应用。

SkyReels-V1 的功能特点:

- 影视级人物微表情演绎

- 支持 33 种细腻人物表情和 400 多种自然动作组合,高度还原真人情感表达。

- 电影级光影艺术

- 基于好莱坞级别的高质量影视数据进行训练,生成的每一帧画面在构图、演员站位、相机角度等方面都具有电影级的质感。

- 视频生成模式多样

- 是开源视频生成模型中参数规模最大且支持图生视频的模型,在同等分辨率下,各项指标达到开源领域的先进水平。

- 人物视频理解能力强

- 作为以人为核心的视频理解多模态大模型,可提升对视频中人物相关内容的理解能力,涵盖影视化表情识别、人物空间位置感知、行为意图理解以及表演场景理解等方面。

- 推理效率极高

- 在自研的推理优化框架“SkyReels-Infer”助力下,推理效率大幅提高。可实现 544p 分辨率下,单台 4090 显卡推理仅需 80 秒,并且支持分布式多卡并行。

SkyReels-V2 与 SkyReels-V1 的对比总结:

| 特点 | SkyReels-V2 | SkyReels-V1 |

|---|---|---|

| 无限时长视频生成 | 支持,通过扩散强迫框架实现 | 不支持,受限于传统模型的时长瓶颈 |

| 影视级视频理解模型 | 集成 SkyCaptioner-V1,显著提升镜头语言理解 | 未集成类似模型,理解能力相对较弱 |

| 运动质量优化 | 通过强化学习优化,生成流畅且逼真的视频内容 | 支持复杂动作组合,但动态质量优化有限 |

| 多任务支持 | 支持 T2V、I2V、故事生成、摄像导演功能 | 主要支持 T2V 和 I2V,功能相对有限 |

| 推理效率 | 支持多 GPU 并行计算,推理效率高 | 推理效率高,但未支持多 GPU 并行计算 |

| 开源程度 | 完全开源,支持学术和工业应用 | 开源,但未明确支持多场景应用 |

SkyReels-V2 在无限时长视频生成、影视级视频理解、运动质量优化和多任务支持等方面进行了显著改进,使其在视频生成领域更具竞争力。

最新热榜

热门工具

热门标签

声音克隆(11) 虚拟人像(1) ai机器人(5) ai创作(14) 文本转语音(25) 人工智能模型(3) ai对话工具(43) ai聊天(41) CogAgent(1) 智能体模型(8) 智能编码(5) 语音合成(8) ai视频精修(8) AI视频创作(50) ai编程(27) ai图片生成(96) 大模型(13) 开源AI(27) ai翻译工具(18) ai小说写作(2) ai浏览器(4) ai电商工具(19) 大语言模型(6) ChatGLM2(1) 多模态(18) ai语音生成(13) ai双语翻译(1) ai文生视频(31) ai写作(26) ai大模型(17)

SkyReels-V2和SkyReels-V1相比,各有什么特点?

SkyReels-V2和SkyReels-V1相比,各有什么特点? Claude 4有什么特点,为什么可以连续编程7个小时?

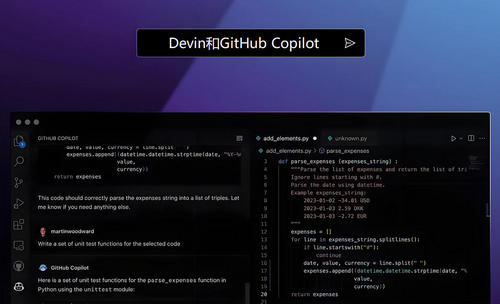

Claude 4有什么特点,为什么可以连续编程7个小时? Devin与GitHub Copilot相比有哪些优缺点?

Devin与GitHub Copilot相比有哪些优缺点? MCP是什么?为什么说谁把它做起来,就拥有AI生态控制权

MCP是什么?为什么说谁把它做起来,就拥有AI生态控制权 几种主流视频生成大模型比较

几种主流视频生成大模型比较 实用好用的AI工具推荐

实用好用的AI工具推荐 通义听悟

通义听悟 智谱清言

智谱清言 Google谷歌翻译

Google谷歌翻译 ChatGPT

ChatGPT 天工AI

天工AI 开拍

开拍