MCP是什么?为什么说谁把它做起来,就拥有AI生态控制权

在人工智能快速发展的今天,大型语言模型(LLM)在各个领域的应用日益广泛。然而,这些模型在实际应用中常常面临数据孤岛和工具集成复杂性的挑战。为了解决这些问题,Anthropic推出了Model Context Protocol(MCP)这一开放协议。MCP旨在定义应用程序和AI模型之间交换上下文信息的方式,使AI模型能够以一致的方式连接各种数据源和工具。简单来说,MCP就像是AI应用的“USB-C接口”,为AI模型与外部工具(如数据库、地图、支付系统等)的连接提供了一个标准化的交互方式。

什么是MCP协议?

MCP,全称Model Context Protocol,即模型上下文协议。这一协议由Anthropic开发,旨在简化大型语言模型与外部数据源和工具之间的通信。可以将MCP想象成AI应用程序的USB-C接口,就像USB-C为设备连接各种外设和配件提供了标准化方式一样,MCP为AI模型连接不同的数据源和工具提供了标准化方式。

MCP协议通过客户端-服务器架构,支持多个服务连接到任何兼容的客户端,提供标准化的、通用的协议共享资源、工具和提示。它使得AI应用能够安全地访问和操作本地及远程数据,为AI应用提供了连接万物的接口。

MCP协议的核心功能

MCP协议的主要功能包括数据集成、工具集成、模板化交互、安全性、开发者支持、预构建服务器和上下文维护。以下是对这些功能的详细解释:

-

数据集成:MCP协议允许AI应用访问本地和远程数据源,包括文件、数据库和外部API。这使得AI模型能够获取更多的上下文信息,从而提高响应的相关性和准确性。

-

工具集成:通过MCP协议,AI应用可以集成各种工具,如实验室检测系统、医学影像分析工具等。这使得AI模型能够执行更复杂的任务,提供更全面的服务。

-

模板化交互:MCP协议支持预先编写的模板(Prompts),这些模板可以帮助用户完成特定任务。模板化交互提高了AI应用的易用性和效率。

-

安全性:MCP协议内置安全机制,保护API密钥不被泄露。它提供了安全的通信方式,确保数据在传输过程中的安全性。

-

开发者支持:Anthropic为MCP协议提供了丰富的开发者资源,包括SDK、文档和社区支持。这使得开发者能够更容易地实现MCP客户端和服务器功能。

-

预构建服务器:Anthropic提供了预构建的MCP服务器,这些服务器可以实现常见的数据源和工具集成。开发者可以直接使用这些预构建服务器,降低开发成本和时间。

-

上下文维护:MCP协议支持上下文信息的维护和管理。这使得AI模型能够在多个交互中保持一致的上下文,提高响应的连贯性和准确性。

MCP协议的工作机制

MCP协议遵循客户端-服务器架构,其中MCP客户端与MCP服务器之间建立一对一的连接。这种设计允许MCP主机(如AI应用程序)通过MCP客户端与一个或多个MCP服务器进行通信,以获取数据和执行任务。

在MCP协议中,标准输入输出(Stdio)和服务器发送事件(SSE)是两种主要的通信方式。Stdio适用于本地进程间通信,其中客户端启动服务器程序作为子进程,消息通讯通过stdin/stdout进行。SSE则用于基于HTTP的通信,允许服务器向客户端推送消息,而客户端到服务器的消息传递则使用HTTP POST。所有传输都使用JSON-RPC 2.0进行消息交换,这为MCP客户端和MCP服务器之间的通信提供了统一的消息格式。

为什么说搞定MCP很重要?

MCP的出现确实引发了全球AI巨头的关注,因为它被视为一种可能统一AI与外部工具交互的标准。如果某个公司能够成功推广MCP并使其成为行业标准,那么它将获得巨大的AI生态控制权。目前,包括阿里、百度、腾讯、华为等在内的多家公司都在积极布局MCP,试图在AI生态中占据主导地位。

然而,MCP目前仍处于发展初期,各公司推出的MCP接口并不完全兼容,形成了各自的生态孤岛。例如,阿里的MCP服务主要面向阿里系产品,而百度则在地图等产品中接入了MCP。这种碎片化的情况使得MCP能否成为统一的AI生态控制权标准仍存在不确定性。

热门工具

热门标签

声音克隆(11) 虚拟人像(1) ai机器人(5) ai创作(14) 文本转语音(25) 人工智能模型(3) ai对话工具(43) ai聊天(41) CogAgent(1) 智能体模型(8) 智能编码(5) 语音合成(8) ai视频精修(8) AI视频创作(50) ai编程(27) ai图片生成(96) 大模型(13) 开源AI(27) ai翻译工具(18) ai小说写作(2) ai浏览器(4) ai电商工具(19) 大语言模型(6) ChatGLM2(1) 多模态(18) ai语音生成(13) ai双语翻译(1) ai文生视频(31) ai写作(26) ai大模型(17)

SkyReels-V2和SkyReels-V1相比,各有什么特点?

SkyReels-V2和SkyReels-V1相比,各有什么特点? Claude 4有什么特点,为什么可以连续编程7个小时?

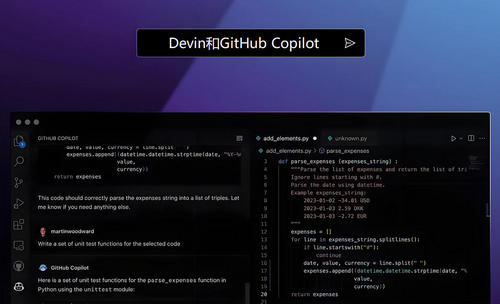

Claude 4有什么特点,为什么可以连续编程7个小时? Devin与GitHub Copilot相比有哪些优缺点?

Devin与GitHub Copilot相比有哪些优缺点? MCP是什么?为什么说谁把它做起来,就拥有AI生态控制权

MCP是什么?为什么说谁把它做起来,就拥有AI生态控制权 几种主流视频生成大模型比较

几种主流视频生成大模型比较 实用好用的AI工具推荐

实用好用的AI工具推荐 通义听悟

通义听悟 智谱清言

智谱清言 Google谷歌翻译

Google谷歌翻译 ChatGPT

ChatGPT 天工AI

天工AI 开拍

开拍